Fallo del Piloto Automático de Tesla Durante una Prueba

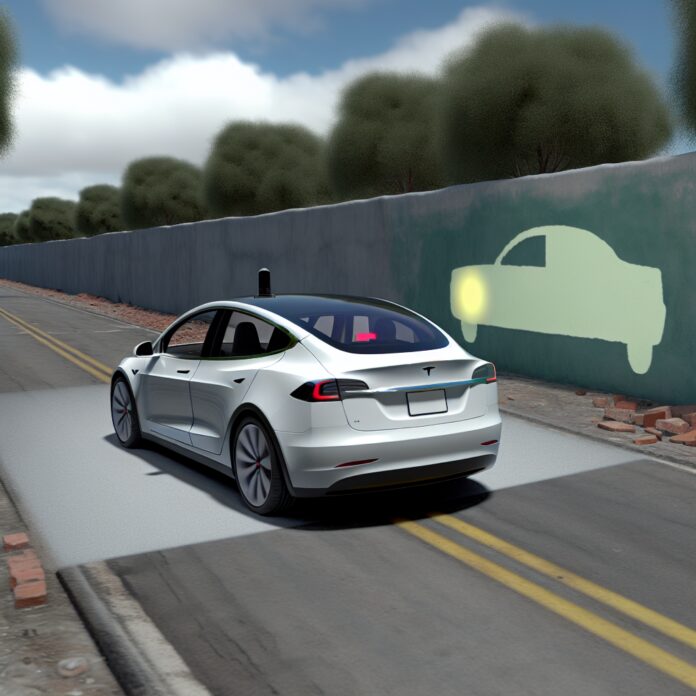

Recientemente, el ingeniero y youtuber Mark Rober realizó una prueba que pone en el centro de la atención el sistema de piloto automático de Tesla, conocido como Autopilot. En un momento crítico, el Tesla Model Y chocó contra una pared pintada, diseñada para simular la continuación de la carretera, sin que el vehículo realizara maniobra alguna para evitar el impacto. Este incidente desafía la confianza que los usuarios y el sector tecnológico han depositado en la autonomía vehicular.

El Incidente y Sus Implicaciones

Durante la prueba, el Autopilot no fue capaz de reconocer la pared debido a su dependiencia exclusiva en la visión computarizada basada en cámaras. En contraste, otros sistemas de conducción autónoma integran tecnología LiDAR, que ha demostrado una mayor efectividad incluso en condiciones adversas. Este fallo pone de relieve las limitaciones del enfoque adoptado por Tesla.

La Estrategia de Tesla y sus Consecuencias

La decisión de Tesla de eliminar radares y LiDAR para confiar únicamente en la visión artificial ha sido defendida por Elon Musk. Sin embargo, los resultados de esta prueba sugieren que podría existir un riesgo inherente a tal estrategia, especialmente ante situaciones inesperadas como la presentada en la prueba de Rober. Este tipo de incidentes no solo impactan la percepción del Autopilot, sino que avivan el debate sobre la seguridad en la conducción autónoma.

Debate en Curso sobre Seguridad y Responsabilidad

A medida que crece la implementación de sistemas de conducción autónoma, las preguntas sobre la seguridad y la responsabilidad se vuelven cada vez más pertinentes. La relación entre el Autopilot y varios accidentes ha generado preocupación a nivel global, resaltando la necesidad de un equilibrio entre innovación y seguridad vial en el desarrollo de tecnología de conducción autónoma.